L’autorità antitrust italiana AGCM ha avviato un’indagine sulla startup di AI cinese DeepSeek per il mancato avviso agli utenti circa il rischio che il modello linguistico producesse informazioni false, un profilo di accusa che si può concretizzare nella definizione della pratica commerciale scorretta. La notizia è stata pubblicata nel bollettino settimanale reso disponibile dall’autorità stessa.

L’AGCM ha precisato che, sulla base di informazioni acquisite ai fini dell’applicazione del Codice del consumo, DeepSeek non ha fornito avvisi “sufficientemente chiari, immediati e comprensibili” sulla possibilità di incorrere nelle cosiddette “allucinazioni” contenute in alcuni suoi prodotti. L’antitrust descrive il termine allucinazione come quella situazione in cui, in risposta ad un input di un utente, il modello di AI “genera uno o più output contenenti informazioni imprecise, fuorvianti o inventate”. Ogni tipo di informazione a riguardo fornito da DeepSeek è stato giudicato dall’Autorità come “eccessivamente generico”.

Il procedimento avviato si concluderà entro 270 giorni e nel frattempo l’Antitrust ha richiesto ulteriori informazioni a DeepSeek. Non è la prima volta che un’autorità italiana interviene sulle società Hangzhou DeepSeek Artificial Intelligence e Beijing DeepSeek Artificial Intelligence, responsabili dello sviluppo e della gestione del sistema di intelligenza artificiale DeepSeek. A febbraio era infatti stata l’Autorità Garante per la protezione dei dati personali ad ordinare a DeepSeek di bloccare l’accesso al suo chatbot nel territorio nazionale a causa delle mancate risposte della società sulla propria politica della privacy.

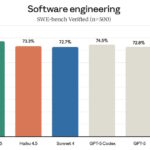

Più i modelli AI sono potenti, più sembrerebbero inclini alle allucinazioni

Tra i molti esempi, o4-mini mostrerebbe un tasso di allucinazione…