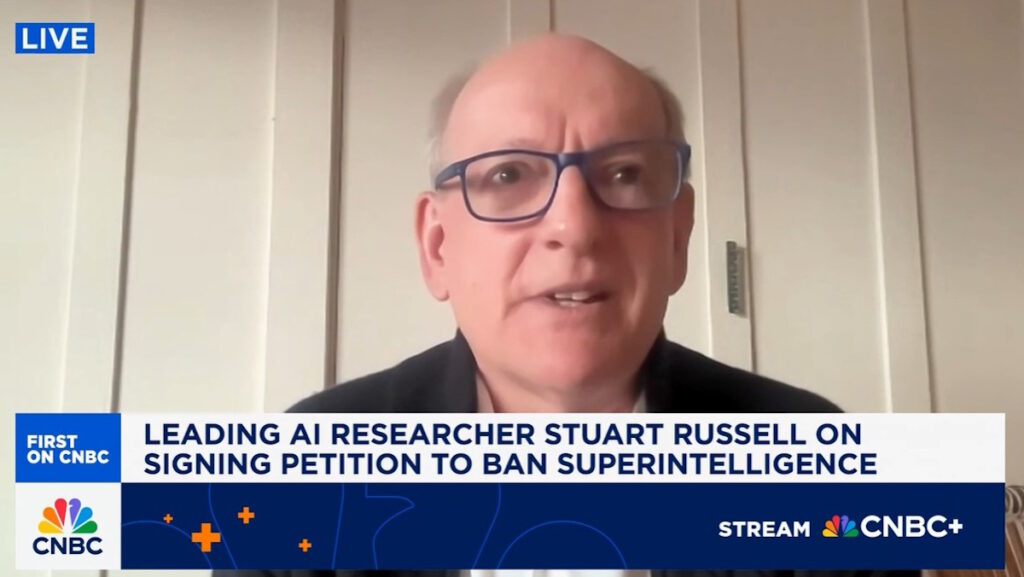

La società statunitense di intelligenza artificiale Anthropic ha annunciato di aver neutralizzato il primo attacco informatico condotto con sistemi agentici di AI. L’azienda ha spiegato che i fatti risalgono a metà settembre 2025, quando sono state rilevate delle attività sospette poi identificate in una “campagna di spionaggio altamente sofisticata” organizzata con “elevata certezza” da un gruppo finanziato dalla Repubblica Popolare Cinese.

Nel condurre l’attacco gli hacker hanno aggirato le misure di sicurezza di Claude Code attraverso una tecnica nota come “jailbreaking”, cioè ingannando l’AI frammentando le istruzioni dannose in compiti apparentemente innocui e facendole credere di stare operando in un ambiente sicuro per lo svolgimento di alcuni test di sicurezza.

L’elemento sorprendente sottolineato dai tecnici di Anthropic è stato il grado di autonomia con cui l’AI ha agito. La campagna è stata condotta quasi interamente dall’AI e l’intervento umano è stato rilevato solamente in cinque o sei fasi critiche dell’attacco. L’operazione, che è stata neutralizzata dalla società con una combinazione di rilevamento tempestivo, analisi e contromisure tecniche, ha preso di mira grandi aziende tecnologiche, istituti finanziari, aziende chimiche e agenzie governative e secondo gli esperti episodi simili in futuro sono destinati a crescere.

Rischi dell'AI: Anthropic ha studiato un filtro per impedire lo sviluppo di un'arma nucleare

Il filtro è in grado di intervenire quando le conversazioni…